Fungsinya robots.txt

Soree,,,

kita mau menjelaskan fungsinya robots.txt biar pada ngarti :3

kita mau menjelaskan fungsinya robots.txt biar pada ngarti :3

Apa sih itu robots.txt dan apa fungsinya? Pernahkah Anda berfikir

seperti itu? Pernahkah terbesit di pikiran Anda untuk mengenal

robots.txt? File text ini sering kali dipandang sebelah mata, padahal

fungsinya sungguh sanggat luar biasa. Mengapa luar biasa? Nanti akan

saya beri gambarannya. Simak terus artikel ini.

Sebelumnya lebih baik kalau kita berkenalan dengan file kecil yang satu ini.

robots.txt merupakan filter bagi website kita, atau bisa juga kita samakan dengan satpam yang ada di depan rumah atau suatu kantor. Kita tahu saptam berguna untuk memfilter siapa saja yang boleh masuk kedalam kantor dan juga memberi arahan akan kemana tamu itu, misal ke resepsionis. Satpam juga memberi larangan agar tamu tidak pergi ke suatu tempat yang tidak semestinya, misal tidak boleh pergi ke gudang, ruang rahasia, dan lainnya.

Sama dengan Satpam, robots.txt juga memberikan arahan dan larangan kepada tamu. Nah, tamu yang dimaksud di sini adalah robot search engine. Katakanlah google. Google punya sebuah robot yang bernama google-bot. Nah, tugas dari google bot ini adalah mencari dan menelusuri setiap website yang terdaftar di google webmaster. Dengan google-bot ini, google mengumpulkan semua hal tentang suatu website, seperti artikel terbaru, halaman login, halaman tertentu, dan lainnya.

Nah, di sinilah peran file kecil bernama robots.txt tadi. Dia (robots.txt) akan memberi arahan dan larangan terhadap google-bot. Misalnya robots.txt memperbolehkan google-bot untuk mengakses suatu folder, atau melarang google-bot mengakses suatu folder. Namun, apabila file robots.txt tidak ditemukan di suatu website, tentu saja google-bot akan se enaknya sendiri menjelajahi website tersebut.

Trus, klo dijelajahi se enaknya oleh google-bot ngaruhnya apa? Ini jelas berbahaya. Karena file-file config, form upload, folder upload, dan file-file rahasia lainnya akan di telusuri oleh google-bot dan menyimpannya ke database google. Sebenarnya ini tidaklah menjadi masalah. Namun masalah akan timbul saat ada orang iseng mencari website sebagai korban hacking iseng di google. Mereka akan dengan mudah menemukan file-file config website kita dan dengan mudah mengakalinya.

Jelaskan, bahwa file robots.txt sangat berguna bagi suatu website. Sekarang kita coba membuat sebuah file robots.txt walaupun sebenarnya banyak website penyedia robots.txt generator.

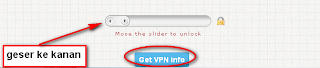

Sebelumnya kita buat sebuah skenario. robots milik search engine tidak boleh mengakses folder config dan admin. Berikut caranya.

Pertama buatlah sebuah file dengan nama robots dan extensi txt jadi, namanya robots.txt kemudian letakkan di folder utama (jika di hosting diletakkan di public_html/www). Kemudian ketik kode berikut (yang berwarna merah).

User-agent : * <-- ini berarti aturan yang ditulis ditujukan untuk semua robots dari semua search engine

Dissallow: /config/ <-- ini berarti melarang robots dari semua search engine untuk menelusuri folder config

Dissallow: /admin/ <-- ini berarti melarang robots dari semua search engine untuk menelusuri folder admin

Kemudian save. Jadilah file robots.txt kita. Simple memang, tapi fungsinya luar biasa.

Demikian tulisan singkat saya mengenai file robots.txt dan fungsinya beserta cara pembuatan robots.txt itu sendiri. Semoga membantu.

Komentar

Posting Komentar